作者 / Google DeepMind 研究副总裁 Clement Farabet 和 Google DeepMind 总监 Tris Warkentin

AI 有可能解决人类面临的一些最紧迫的问题,但前提是每个人都拥有构建 AI 的工具。这就是我们在今年早些时候 推出 Gemma 的原因,Gemma 是一系列轻量级开放模型系列,采用了与创建 Gemini 模型 相同的研究和技术。我们还陆续推出了 CodeGemma、RecurrentGemma 和 PaliGemma,以此不断发展我们的 Gemma 系列,上述每个模型都能为不同的 AI 任务提供独特的功能,并且可以通过与 Hugging Face、NVIDIA 和 Ollama 等合作伙伴的集成轻松访问。

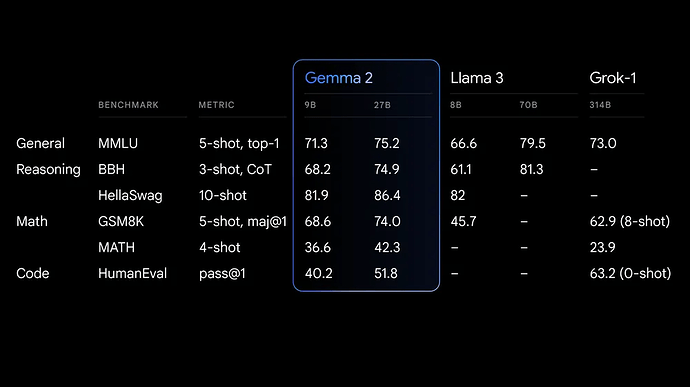

现在,我们正式向全球研究人员和开发者发布 Gemma 2。Gemma 2 分为 90 亿 (9B) 和 270 亿 (27B) 两种参数版本,与第一代相比,其性能更强、推理效率更高,并且在安全性方面也有显著提升。事实上,作为一种有竞争力的替代方案,Gemma 2 27B 的性能可以与规模是其两倍的模型相媲美,截至去年 12 月,只有专有模型才能达到此性能水准。如今,这可以在单个 NVIDIA H100 Tensor Core GPU 或 TPU 的主机上实现,从而显著降低了部署成本。

效率与性能跃阶的全新开放模型标准

我们在重新设计的架构上构建了 Gemma 2,旨在提供卓越的性能和推理效率。以下是它脱颖而出的原因:

- 非凡性能: Gemma 2 27B 在同类规模的模型中性能最优,甚至比其规模大两倍以上的模型更具竞争力。而 Gemma 2 9B 模型也具有一流的性能,优于 Llama 3 8B 以及其他相同规模类别的开放模型。如需了解详细性能分析,请查阅 技术报告。

- 立竿见影的降本增效: Gemma 2 27B 模型旨在助您使用单个 Google Cloud TPU 主机、NVIDIA A100 80GB Tensor Core GPU 或 NVIDIA H100 Tensor Core GPU 以全精度高效运行推理,从而显著降低成本,同时保持高效性能。这使得 AI 部署更加易于访问且经济实惠。

- 跨硬件的极速推理: Gemma 2 经过优化,可以在一系列硬件上以不可思议的速度运行,包括强大的游戏本电脑、高端台式机和云端配置等。您可以在 Google AI Studio 中以全精度体验 Gemma 2,在 CPU 上使用 Gemma.cpp 量化版本解锁本地性能,或者通过 Hugging Face Transformer 在配备 NVIDIA RTX 或 GeForce RTX 的家用电脑上试用。

专为开发者和研究人员打造

Gemma 2 不仅功能更强大,并且还能够更轻松地集成到您的工作流程中:

- 开放且易于访问: 就像最初的 Gemma 模型一样,Gemma 2 可在我们商业友好型的 Gemma 许可 下使用,支持开发者和研究人员分享和商业化他们的创新成果。

- 广泛的框架兼容性: 由于 Gemma 2 与 Hugging Face Transformer 等主要 AI 框架兼容,并且通过原生 Keras 3.0、vLLM、Gemma.cpp、Llama.cpp 和 Ollama 兼容 JAX、PyTorch 和 TensorFlow,因此您可以轻松地将其与您偏好的工具和工作流一起使用。此外,我们还通过 NVIDIA TensorRT-LLM 优化了 Gemma,支持该模型在 NVIDIA 加速基础架构上运行,或作为 NVIDIA NIM 推理微服务运行,并将很快优化支持 NVIDIA NeMo。您现在便可以使用 Keras 和 Hugging Face 进行微调。我们正在积极努力,以提供更多参数高效的微调选项。

- 轻松部署: 从七月开始,Google Cloud 客户将能够在 Vertex AI 上轻松部署和管理 Gemma 2。

探索新的 Gemma 手册,其中包含一系列实用示例和指南,帮助您构建自己的应用并针对特定任务微调 Gemma 2 模型。还可了解如何轻松使用您的工具与 Gemma 集成,包括用于如检索增强生成等常见任务。

负责任的 AI 开发

我们致力于为开发者和研究人员提供负责任地构建和部署 AI 所需的资源,包括使用我们 负责任的生成式 AI 工具包 (Responsible Generative AI Toolkit)。最近开源的 LLM Comparator 可帮助开发者和研究人员深入评估语言模型。现在,您可以使用配套的 Python 库对您的模型和数据 进行比较评估,并在应用中可视化结果。此外,我们正在积极致力于为 Gemma 模型开源文本水印技术 SynthID。

在训练 Gemma 2 时,我们遵循稳健的内部安全流程和过滤预训练数据,并根据一套全面的指标开展严格的测试和评估,以识别和减轻潜在的偏见和风险。我们在大量的与安全和代表性危害相关的公共基准上发布我们的结果。

使用 Gemma 构建的项目

我们首次推出 Gemma 时获得了超过 1,000 万次的下载量,并促成了无数鼓舞人心的项目。例如,Navarasa 利用 Gemma 创建了一个基于印度语言多样性的模型。

如今,Gemma 2 将帮助开发者落地更具雄心的项目,在他们的 AI 创作中释放全新的性能和潜力。我们将不懈地探索新的架构,并开发专门的 Gemma 变体,以应对更广泛的 AI 任务和挑战。这包括即将推出的Gemma 2 2.6B 模型,旨在进一步弥合轻量级可访问性与强大性能之间的差距。您可以参阅 技术报告 以详细了解。

开始构建

Gemma 2 现已在 Google AI Studio 中推出,因此您可以在无需硬件要求的情况下测试 Gemma 2 27B 的全部性能。您还可以从 Kaggle 和 Hugging Face 模型 下载 Gemma 2 的模型权重,Vertex AI Model Garden 中也即将推出。

为了方便研究和开发,您还可通过 Kaggle 或 Colab notebook 免费使用 Gemma 2。首次使用 Google Cloud 的用户可能有资格获得 300 美元积分。学术研究人员可以通过申请 Gemma 2 学术研究计划 (Gemma 2 Academic Research Program) 获取 Google Cloud 积分,从而加速 Gemma 2 的研究。申请 现已开放,截止日期为 8 月 9 日。