每一周,我们的同事都会向社区的成员们发布一些关于 Hugging Face 相关的更新,包括我们的产品和平台更新、社区活动、学习资源和内容更新、开源库和模型更新等,我们将其称之为「Hugging News」。

下面是本期的 Hugging News 内容:

HuggingFace hub webhook

想要写个程序自动抓取 HF 上模型或者数据集的更新,来个 bot 自动介入讨论区的互动?来玩 webhooks 吧~

Hugging Face Competitions 平台

AI 时代的 OJ 是什么样子?来试试最新的 AI 比赛平台吧。AI 图片生成挑战赛已开幕,还有奖金哦~

Diffusers 0.12 发布

有了 InstructPix2Pix, LoRA, fast DEIS scheduler, DiT (Diffusion Transformers), customizable attention layers 你想做什么应用呢?评论区告诉我们吧。

微调过的文生图模型能有多小?

答案:3.3 MB

KerasCV <-> Diffusers

Keras CV 的 Stable Diffusion 模型也可以在 Diffusers 上部署啦!

TRL 0.2.0 来啦

LLM + RL (RLHF) 用这个框架就好啦

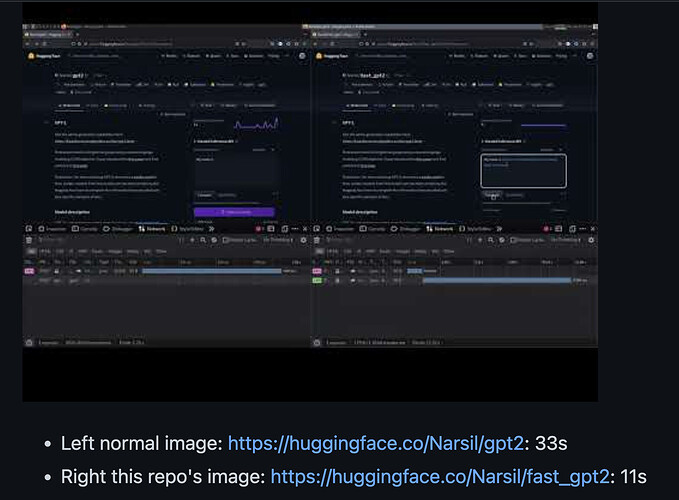

Fast GPT2

用 Rust 写的 GPT2,比 PyTorch 快三倍。

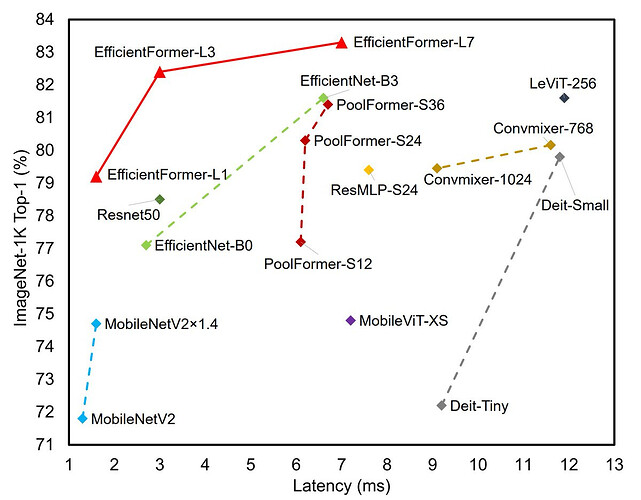

手机上能跑的 Transformer 来了

用这个用来做图像分类也太强了吧!

Model: EfficientFormer

Demo: EfficientFormer - a Hugging Face Space by adirik

再次恭喜所有在 DreamBooth 微调竞赛中获奖的参赛者

上一篇文章我们向大家展示了 来自全球参赛者的「AIGC」作品,我们在国内做了竞赛的「分会场」,目标是希望将难度将至最低,让每个人都能体验一下当下这个最火热的概念。本次活动已经圆满落幕,下次活动见!