每一周,我们的同事都会向社区的成员们发布一些关于 Hugging Face 相关的更新,包括我们的产品和平台更新、社区活动、学习资源和内容更新、开源库和模型更新等,我们将其称之为「Hugging News」。本期 Hugging News 有哪些有趣的消息,快来看看吧! ![]()

![]()

重磅更新

ChatUI:官方 Docker 模板发布,一键部署自己的聊天应用!

ChatUI:官方 Docker 模板发布,一键部署自己的聊天应用!

Hugging Chat 是一个开源的聊天工具,大家在这里可以尝试使用开源的大型语言模型,如 Falcon、StarCoder 和 BLOOM。现在我们提供了名为 ChatUI 的官方 Docker 模板,你可以在这里使用 Hugging Face 的基础架构,基于你选择的模型来部署自己的 Hugging Chat。只需点击几下,即可部署你自己的 Llama 2、Falcon 或 OpenAssistant 聊天界面!![]()

点击这个链接即可开始使用:https://hf.co/new-space?template=huggingchat/chat-ui-template

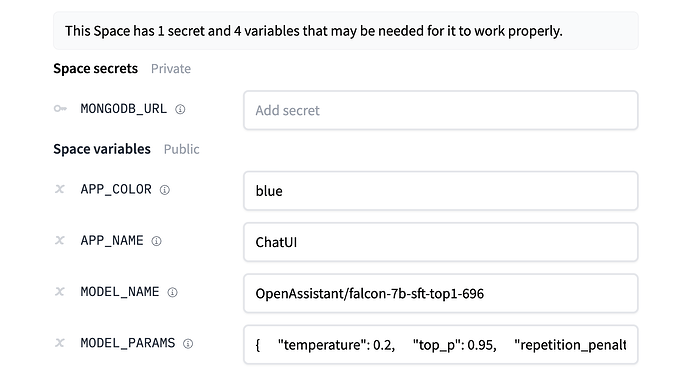

这个应用的后端使用了文本生成推理来实现更优化的模型推断。由于这些模型无法在 CPU 上运行,你可以根据你选择的模型来选择使用 GPU。你需要提供一个 MongoDB 终端,用于存储聊天记录。如果你不提供 MongoDB 的终端,你的日志将保存在 Space 内的数据库中。Hugging Face 无法访问你的聊天记录。

你可以提供应用名称和应用颜色参数,从而配置 Space 的名称和主题。之后你可以选择要提供服务的模型的 Hugging Face Hub ID。你还可以在下面的 JSON 格式字典中更改生成超参数。

创建完成后,你将在你的 Space 上看到「正在构建」。构建完成后,你就可以尝试你自己的 HuggingChat 了!![]()

![]()

更多信息可以参考 ![]() https://hf.co/docs/hub/spaces-sdks-docker-chatui

https://hf.co/docs/hub/spaces-sdks-docker-chatui

产品更新

Transformers.js v2.5.0 发布!

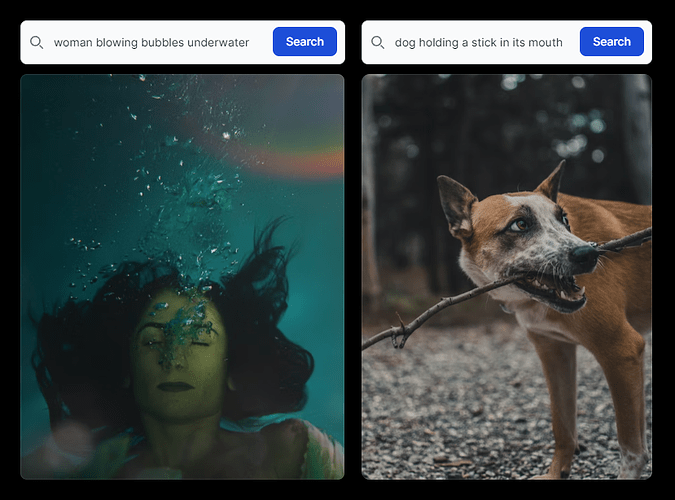

你是否曾经想过在 Next.js 中构建自己的语义图像搜索应用程序?现在你可以实现了!

在 Transformers.js v2.5.0 版本中,新增了对使用 CLIP 计算嵌入的支持,现在你可以单独计算 CLIP 文本和视觉嵌入,这使得在只需要查询其中一种模态性时可以更快地进行推理。![]()

CLIP(Contrastive Language-Image Pretraining)是由 OpenAI 开发的一种多模态预训练模型,用于处理图像和文本数据。CLIP 可以将图像和文本输入映射到一个共享的高维向量空间中,使得图像和文本可以在同一空间中进行比较和匹配。这种能力使得 CLIP 在图像分类、图像搜索、图像生成和文本理解等任务中表现出色,比如通过文本描述来搜索图像,或者通过图像内容来理解文本。这种多模态的处理能力使得 CLIP 在各种人工智能和机器学习任务中具有广泛的应用价值。![]()

![]()

和往常一样,我们已在 GitHub 上发布了演示的源代码! ![]() 你也可以从零开始,只需几行代码即可入门。

你也可以从零开始,只需几行代码即可入门。

源代码:https://github.com/xenova/transformers.js/tree/main/examples/semantic-image-search

发布说明:https://github.com/xenova/transformers.js/releases/tag/2.5.0

演示:https://hf.co/spaces/Xenova/semantic-image-search

在之前的 v2.4 更新中,我们新增了对使用 Whisper 生成单词级时间戳的支持。只需几行代码,你就可以在浏览器中完美地为视频添加字幕。![]()

![]() 生成单词级时间戳指的是将音频中的每个单词与其开始和结束的时间戳进行匹配,从而准确地确定每个单词的发音时长和位置。

生成单词级时间戳指的是将音频中的每个单词与其开始和结束的时间戳进行匹配,从而准确地确定每个单词的发音时长和位置。

我们新增了通过分析交叉注意力并应用动态时间扭曲,为我们的 Whisper 自动语音识别模型预测单词级时间戳的功能。![]()

![]()

交叉注意力(Cross Attentions):在深度学习中,注意力机制用于模型对输入数据的不同部分赋予不同的重要性。交叉注意力指的是模型中不同层或组件之间的注意力交互。模型在处理输入文本的不同位置时,会关注其他部分的信息。在这里,交叉注意力可用于指导模型将注意力集中在音频中特定的语音片段上,从而识别单词的开始和结束。![]()

![]()

动态时间扭曲(Dynamic Time Warping):动态时间扭曲是一种用于序列对齐的技术,通常用于比较两个不同长度的序列,以找到它们之间的最佳匹配。在这里,动态时间扭曲可以通过调整时间轴上的插值来对齐输入音频和生成的单词级时间戳序列,以确保它们在时间上正确对应。![]()

![]()

Hugging Face 第一本中文图书正式出版!

在 Hugging Face ![]() 团队和中国社区

团队和中国社区![]() 以及人民邮电出版社的编辑团队的共同帮助下,「扩散模型:从原理到实战」正式出版!

以及人民邮电出版社的编辑团队的共同帮助下,「扩散模型:从原理到实战」正式出版!![]()

![]()

扩散模型我们如今已经都不陌生,它是我们熟知的当下流行的 AI 绘图背后的技术。这本书由 Hugging Face 中国社区的本地化志愿者团队成员完成,书的内容基于由 Hugging Face 成员 Jona 和 Lewis 在 Hugging Face 上发布的扩散模型课程。

在本书中,你可以了解到扩散模型的原理、发展与应用,并且尝试使用 Hugging Face Diffusers 库训练扩散模型,我们也在书里对 Hugging Face Hub、开源库以及相关的学习资源进行了介绍,内容非常丰富。![]()

![]()

无论你是新手还是经验丰富的从业者,这本以实战为导向的图书都能够帮助你更好的理解和应用扩散模型。

——王铁震,Hugging Face 中国地区负责人,高级工程师

我们从出版社拿到了五折的购买链接,欢迎各位奔走相告![]() ,让更多小伙伴了解这本书。再次感谢所有本书的参与者!五折购书链接

,让更多小伙伴了解这本书。再次感谢所有本书的参与者!五折购书链接 ![]() https://item.jd.com/13803847.html

https://item.jd.com/13803847.html

社区活动

「科普讲座」:Hugging Face 是什么?

我们帅气优秀的 Hugging Face Fellow 程路受 Intel OpenVINO - DEVOON 中国工作坊的邀请,做了一场关于「Hugging Face Hub 与开源生态介绍」的中文讲座 ![]()

![]()

![]()

这场讲座的内容丰富,可以让大家对我们的工作和 Hub 的内容有更加完整的理解和认识 ,![]() 视频在这里查看

视频在这里查看![]() :【中文科普: Hugging Face 是什么?】🤗 Hugging Face Hub 和开源生态介绍_哔哩哔哩_bilibili

:【中文科普: Hugging Face 是什么?】🤗 Hugging Face Hub 和开源生态介绍_哔哩哔哩_bilibili

你还想看到我们发布哪些内容呢?欢迎留言告诉我们 ![]()

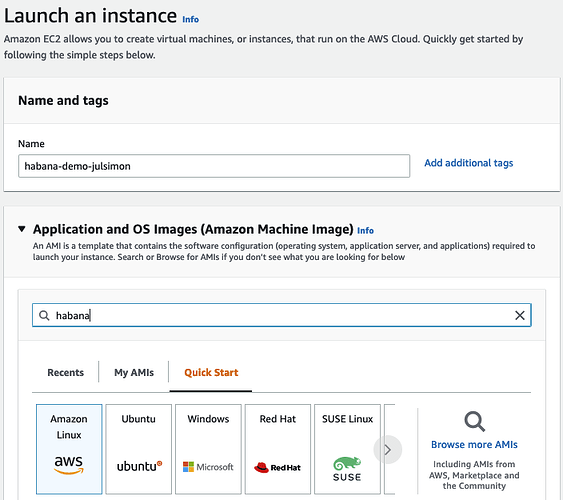

基于 Habana Gaudi 的 Transformers 入门

几周前,我们很高兴地宣布 Habana Labs 和 Hugging Face 将开展加速 Transformers 模型的训练方面的合作。![]()

与最新的基于 GPU 的 Amazon Web Services (AWS) EC2 实例相比,Habana Gaudi 加速卡在训练机器学习模型方面的性价比提高了 40%。我们非常高兴将这种性价比优势引入 Transformers ![]() 。

。

在以下这篇文章中,我们将手把手向你展示如何在 AWS 上快速设置 Habana Gaudi 实例,并用其微调一个用于文本分类的 BERT 模型。与往常一样,我们提供了所有代码,以便你可以在自己的项目中重用它们。文章链接![]() :https://mp.weixin.qq.com/s/WvZCj75bFXTlLJteEIrefQ

:https://mp.weixin.qq.com/s/WvZCj75bFXTlLJteEIrefQ

本期内容编辑: Shawn

以上就是本期的 Hugging News,新的一周开始了,我们一起加油! ![]()

![]()